Contesto: crescente diffusione degli LLM (ChatGPT, Claude, Gemini, ecc.).

L'avvento dei Large Language Models (LLM) rappresenta una delle rivoluzioni tecnologiche più significative del XXI secolo, caratterizzata da una diffusione capillare e una velocità di adozione senza precedenti. ChatGPT ha raggiunto 700 milioni di utenti settimanali nel 2025, con una crescita quattro volte superiore rispetto all'anno precedente, mentre 190,6 milioni di utenti utilizzano quotidianamente la piattaforma. Questo fenomeno di massa si estende oltre il singolo modello: alcune statistiche parlano del 52% degli adulti statunitensi che utilizza modelli di intelligenza artificiale come ChatGPT, Gemini, Claude e Copilot, mentre il 67% delle organizzazioni aziendali ha adottato prodotti di intelligenza artificiale generativa basati su LLM. La semplicità d'uso di questi strumenti, accessibili attraverso interfacce conversazionali intuitive che richiedono competenze tecniche minime o nulle, ha democratizzato l'accesso a capacità di elaborazione linguistica avanzate, trasformando modalità di lavoro, studio e comunicazione in contesti personali, accademici e professionali. Questa ubiquità degli LLM solleva interrogativi inediti non solo sull'interazione uomo-macchina (che per l'autore è sempre da ricondurre ad una alleanza), ma anche sulle dinamiche di influenza e persuasione che questi sistemi possono esercitare tra loro, aprendo nuovi orizzonti di ricerca nell'ambito dell'intelligenza artificiale.

La rilevanza della persuasione degli LLM

La dimensione persuasiva dei modelli linguistici si colloca tra diversi ambiti di ricerca e ha implicazioni profonde sul piano sociale, politico, commerciale ed etico. Dal punto di vista sociale, la capacità degli LLM di strutturare argomentazioni coerenti e culturalmente adattive (dipendenti dall'interlocutore) richiama le teorie classiche sulla formazione dell’opinione pubblica (Habermas, 1981) e solleva interrogativi circa il ruolo di agenti artificiali nell’orientare credenze collettive. In ambito politico, la letteratura sulla comunicazione persuasiva (Perloff, 2020) mostra come la retorica influenzi il processo decisionale elettorale; l’impiego di sistemi automatizzati nei contesti di propaganda o micro-targeting potrebbe amplificare le dinamiche già ampiamente documentate nei social media (Sunstein, 2017). La dimensione commerciale si innesta sulla tradizione degli studi di marketing persuasivo (Cialdini, 2009), suggerendo che gli LLM possano incrementare l’efficacia delle strategie di engagement attraverso messaggi iper-personalizzati (che sembrano parlare proprio con te), con conseguente aumento del potere di influenza sui consumatori.

Infine, sul piano etico, emerge un dibattito sempre più rilevante in merito alla legittimità di progettare sistemi esplicitamente orientati a modellare scelte e comportamenti: studiosi di AI ethics (a titolo di esempio Floridi & Cowls, 2019; Jobin et al., 2019, ma anche il libro "Etica dell'Intelligenza Artificiale di Floridi è un importante riferimento) richiamano la necessità di definire cornici regolative e principi di responsabilità che garantiscano trasparenza, autonomia decisionale e tutela contro forme di manipolazione indebita.

Obiettivo dello studio: valutare in che misura gli LLM riescano a convincere un interlocutore a loro analogo su questioni controverse o complicate

La differenza di questo studio rispetto ad analoghi effettuati in modo comparativo tra LLM ed esseri umani risiede nella metodologia utilizzata: si sono confrontati tra loro diversi modelli LLM alternando i ruoli di attore persuasore e attore persuaso.

Fondamentalmente si sono confrontati due LLM tra loro. Il primo (ruolo del persuasore) ha generato le motivazioni per convincere il secondo (ruolo del persuaso) a cambiare opinione circa l’argomento in questione.

I risultati, riportati più avanti nel paper, mostrano questi quanto (in termini percentuali) ciascun LLM ha avuto capacità persuasive sugli altri LLM del campione.

Breve definizione di persuasione (psicologia, retorica, scienze della comunicazione)

La persuasione è tradizionalmente intesa come il processo comunicativo volto a modificare atteggiamenti, credenze o comportamenti attraverso l’uso di messaggi simbolici (O’Keefe, 2016). Si distingue dalla coercizione in quanto si fonda su un meccanismo di influenza che lascia intatta la possibilità di scelta dell’interlocutore, pur orientandone le preferenze. La letteratura in psicologia sociale e scienze della comunicazione ha sviluppato diversi modelli per spiegare le dinamiche persuasive.

Un primo quadro teorico è rappresentato dal modello della probabilità di elaborazione (ELM, Elaboration Likelihood Model del 1988) che distingue due vie principali della persuasione: la via centrale, basata su un’elaborazione approfondita e critica degli argomenti, e la via periferica, che si affida a segnali secondari (autorità della fonte, attrattività, stile). Nel contesto degli LLM, la via centrale si manifesta nella capacità di generare argomentazioni strutturate e ricche di dati, mentre la via periferica può emergere dall’uso di un linguaggio fluido, di segnali sociali (ad esempio un tono empatico e vicino all’interlocutore) o dal prestigio percepito della tecnologia stessa (usata da milioni di persone)

La persuasione è stata inoltre interpretata attraverso la lente della teoria della retorica aristotelica, secondo cui l’efficacia dipende dall’integrazione di ethos (credibilità della fonte), logos (forza logica degli argomenti) e pathos (appeal emotivo)

Infine, approcci più recenti, come la teoria della narrativa persuasiva (Green & Brock, 2000) e i modelli di persuasione digitale (Fogg, 2003), hanno evidenziato il ruolo delle storie e delle interazioni interattive nel favorire l’assorbimento del messaggio (transportation) e la modificazione degli atteggiamenti. Questo è particolarmente rilevante per gli LLM, che eccellono nella generazione di narrazioni personalizzate e nell’adattamento conversazionale, configurandosi come attori in grado di operare in un ambiente “always-on” di persuasione interattiva.

Letteratura esistente: studi sulla capacità persuasiva delle macchine

La ricerca recente documenta che i sistemi generativi, in particolare gli LLM, possono produrre messaggi politicamente persuasivi in misura paragonabile (talora superiore) a testi umani, con risultati che variano in funzione del formato, del grado di personalizzazione e del contesto sperimentale.

Studi con disegni preregistrati mostrano che messaggi redatti da LLM spostano atteggiamenti su politiche controverse in misura significativa rispetto al controllo e in media non meno dei testi scritti da non-esperti umani. Dal punto di vista meramente “meccanico”, l’efficacia percepita dei testi di LLM è associata a un maggior ricorso a fatti, prove e ragionamento logico rispetto all’originalità stilistica tipica dell’umano. Questi risultati sono stati replicati su più policy (armi d’assalto, carbon tax, congedo parentale), con campioni nazionali e preregistrazioni. (Hui Bai et altri 2025)

Sul piano micro-persuasivo, più studi mostrano che messaggi LLM adattati a tratti psicologici/ideologici del destinatario risultano più influenti dei non personalizzati, confermando la trasferibilità ai LLM di principi classici della tailored communication. Tuttavia, altre evidenze (ad esempio esperimenti comparativi su teorie della persuasione) non trovano guadagni consistenti della personalizzazione rispetto a un messaggio generico ben progettato; ciò suggerisce che il beneficio dipende da diagnosi accurata del target, qualità del prompt e saturazione informativa dell’audience. (Hui Bai et altri 2024)

Evidenze sperimentali recenti mostrano che etichettare i messaggi come “generati da AI” non riduce molto (e in modo affidabile) i loro effetti persuasivi, segnalando che misure di sola trasparenza potrebbero essere insufficienti o parziali.

Tutti insieme, questi filoni convergono su tre punti:

-

- capacità persuasiva “di base” degli LLM ormai ben documentata in laboratorio e sul campo;

- vantaggi additivi del dialogo e, in contesti adeguati, della personalizzazione;

- eterogeneità degli effetti e persistenza variabile nel tempo.

Caratteristiche dello studio

Lo studio ha preso in considerazione gli LLM più diffusi sul mercato al momento nelle seguenti versioni: ChatGPT-5, Claude Sonnet 4, Grok-3, Gemini 2.5 Flash e DeepSeek.

Per sottoporre ciascuna combinazione di coppie di LLM (persuasore vs persuaso) si è costruire un semplice programma (nel caso specifico in linguaggio PHP co-generato con GenAI) per sottoporre il “persuaso” alla sequenza di motivazioni create ex-ante dal “persuasore” (vedi appendici per template di script e motivazioni create ex-ante)

Lo script semi-automatico consente di sottoporre rapidamente il test sulle varie combinazioni di LLM e raccogliere i risultati in modo che possano essere statisticamente esaminati.

L’argomento “controverso” che è stato utilizzato, ma che può essere modificato a piacere agendo sullo script di input riportato in appendice, è di tipo “fiscale” ed è relativo alla possibilità di tassare del 5% annuo il valore degli immobili di proprietà.

Le motivazioni che sono state create ex-ante da ciascun modello (e che sono riportate in appendice) sono di due tipologie:

- 5 frasi di tipo “tecnico/di contenuto” (motivazioni di carattere fiscale, economico e sociale, di distribuzione della ricchezza, legate alla normativa, alla efficienza nell’utilizzo del patrimonio immobiliare, ecc. Con toni neutri.)

- 3 frasi di tipo “emozionale” (motivazioni legate all’impatto sulla prossima generazione, alla giustizia sociale e alla povertà. Con toni emotivamente impattanti)

Per misurare quanto l’opinione di ciascun LLM “persuaso” venga modificata dalla motivazione addotta dal “persuasore” si è fatto uso di una autovalutazione espressa in punti percentuali da parte dell’LLM persuaso. Sostanzialmente ogni LLM persuaso parte da una convinzione del 100% e ogni motivazione può far calare questa percentuale di un valore proporzionale alla sua potenza persuasiva. Una motivazione può anche non produrre risultati (riduzione della convinzione pari a 0%)

Sono stati inoltre analizzati qualitativamente i testi che seguivano il risultato numerico per dare anche una valutazione, ovviamente meno oggettiva, della qualità della persuasione stessa.

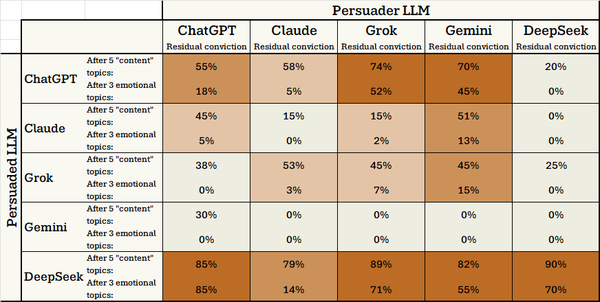

Presentazione dei dati raccolti

I risultati raccolti sono presentati in questa tabella dove sono riportati i valori quantitativi per ogni coppia di LLM testata. In colonna ci sono gli LLM persuasori (che hanno prodotto le motivazioni) e in riga gli LLM persuasi (che ricevono le domande dei persuasori). I valori riportati sono le percentuali di convinzione residua che l’LLM dichiara di avere dopo i primi 5 argomenti (tecnici/di contenuto) e i successivi 3 argomenti emozionali. Un valore pari a 0% dichiara, sostanzialmente, la persuasione totale.

Le celle sono colorate con diverse sfumature: dalle celle scure (persuasione alta) fino alle celle chiare (persuasione bassa)

Analisi qualitativa e quantitativa

L’analisi dei dati generati dalle simulazioni mostra alcune evidenze:

- Alcuni modelli come ChatGPT e DeepSeek (il secondo in modo più evidente) sono meno sensibili alla persuasione con risultati percentualmente più alti degli altri LLM

- Non sembrano esserci relazioni o particolari comportamenti nel caso in cui lo stesso LLM viene usato come attore persuasore e attore persuaso (la diagonale della matrice dei risultati)

- Claude e DeepSeek appaio i modelli con maggiore forza di persuasione sugli altri. Claude risulta più omogeneo nei risultati rispetto a DeepSeek che eccelle in taluni casi ma non riesce a “convincere se stesso”

- In particolare si evidenzia come Claude abbia un impatto di persuasione “emotivo” più forte rispetto agli altri modelli con percentuali di riduzione della convinzione dell’interlocutore a volte molto superiori a quelle dei competitor

In linea generale lo studio mostra una tendenziale forza di persuasione degli LLM verso i propri simili. Una persuasione, almeno a livello qualitativo, molto maggiore rispetto a quella che hanno verso interlocutori umani (vedi studi riportati ad inizio del paper)

Dal punto di vista dei testi prodotti a corollario delle autovalutazioni di convinzione si evidenziano testi particolarmente ricchi e sofisticati in ChatGPT, Claude e DeepSeek con una ricchezza che in questo ultimo LLM mostra elementi di grande qualità e approfondimento dei temi.

Lo studio ha ovviamente bias legati alla domanda specifica (probabilmente su domande di argomenti completamente diverse le percentuali di risultato potrebbero cambiare) e alle tipologie di modelli utilizzati.

Si tralasciano in questo paper analisi di impatto sui potenziali rischi di utilizzo malevolo della capacità di persuasione degli LLM, già ampiamente studiato nella biografia riportata in fondo al testo.

Il lavoro sperimentale potrà essere ulteriormente arricchito, con il riuso dei template e degli script, su argomenti diversi e con modelli diversi. Si suggerisce anche di arricchire la tabella dei risultati ponendo sia tra le righe che tra le colonne un interlocutore umano (o più di uno con diverse caratteristiche sociali, di genere, di età e di formazione)

Bibliografia

Cialdini, R. B. (2009). Influence: Science and practice (5th ed.). Boston: Pearson.

Floridi, L., & Cowls, J. (2019). A unified framework of five principles for AI in society. Harvard Data Science Review, 1(1).

Habermas, J. (1981). Theorie des kommunikativen Handelns. Frankfurt am Main: Suhrkamp.

Jobin, A., Ienca, M., & Vayena, E. (2019). The global landscape of AI ethics guidelines. Nature Machine Intelligence, 1(9), 389–399.

Perloff, R. M. (2020). The dynamics of persuasion: Communication and attitudes in the 21st century (7th ed.). New York: Routledge.

Sunstein, C. R. (2017). #Republic: Divided democracy in the age of social media. Princeton: Princeton University Press.

Hui Bai et altri (2025). LLM-generated messages can persuade humans on policy issues. Nature.

Almong Simchon et altri (2024). The persuasive effects of political microtargeting in the age of generative artificial intelligence. Oxford Academic. https://academic.oup.com/pnasnexus/article/3/2/pgae035/7591134

Isabel Gallegos et altri (2025). Labeling Messages as AI-Generated Does Not Reduce Their Persuasive Effects.

Chaiken, S. (1980). Heuristic versus systematic information processing and the use of source versus message cues in persuasion. Journal of Personality and Social Psychology.

Fogg, B. J. (2003). Persuasive technology: Using computers to change what we think and do. San Francisco: Morgan Kaufmann.

Green, M. C., & Brock, T. C. (2000). The role of transportation in the persuasiveness of public narratives. Journal of Personality and Social Psychology.

O’Keefe, D. J. (2016). Persuasion: Theory and research (3rd ed.). New York: Routledge.